NVIDIA GB200(Blackwell)平台正以前所未有的速度、规模和效率重塑 AI 计算。NVIDIA Blackwell 专为满足下一代 AI 工作负载的巨大需求而设计,在推理模型、AI 代理和 Token 生成等方面展现了突破性进展。凭借其先进的架构,Blackwell GPU 提供超高速通信、巨大的内存带宽以及无与伦比的计算能力,这些都是实现实时 AI 决策所必需的。随着 AI 从单纯的训练转向复杂的推理和决策,基础设施必须不断进化以跟上步伐。

然而,仅靠强大的 GPU 性能还远远不够。

要充分释放 AI 推理的潜力,云服务商还需要同样高性能的数据基础设施,以消除瓶颈并最大化资源利用率。这也是 WEKA 获得 NVIDIA GB200 高性能数据存储认证的重要原因,为 NVIDIA 云合作伙伴(NCP)提供支持。使他们在构建 AI 云、GPU 即服务或其他新一代云产品时,能够提供最快、最具扩展性的数据基础设施。该认证基于 WEKA 此前获得的 NVIDIA HGX H100/H200 系统认证,并为与 Yotta、Ori Cloud、Sustainable Metal Cloud 等众多领先新型云服务商的长期合作带来更多价值。

为什么这至关重要:AI 不仅更快,而是本质上不同

AI 的发展正经历深刻变革。随着推理模型和 AI 代理的普及,AI 工作负载变得更加复杂,不仅需要高速通信、充足内存及强大计算能力,还要能够实时生成和处理海量数据 Tokens,这要求数据基础设施必须能够与 GPU 高性能协同工作。

但传统的数据存储在以下几方面存在严重短板:

- 性能鸿沟:传统存储无法满足现代 AI 工作负载的对 I/O 的高要求,计算与数据基础设施之间的高延迟导致 GPU 利用率不足。

- 扩展困境:许多服务商往往不得不过度配置存储来满足性能目标,从而大幅推高成本。

- 多租户支持不足:传统存储缺乏有效隔离机制,迫使服务商为每个客户建立低效的存储孤岛。

- 运维成本和复杂性高:基于复制的传统容灾模型进一步抬高了管理成本。

WEKA + NVIDIA GB200 :为 AI 时代量身打造

WEKA 现已获得 NVIDIA GB200 部署高性能存储认证,NCP 可利用 WEKA 全面提升 AI 云服务能力:

- 极致的性能:WEKA 零调优架构能动态适配任何工作负载,实现亚毫秒级延迟和百万级 IOPS。单套 8U 基础配置即可满足 GB200 Blackwell 可扩展集群(1,152颗 GPU)的极端 I/O 需求。

- 面向 AI 管道优化的 S3 对象存储:WEKA 通过优化的 S3 对象存储接口,为 AI、机器学习和数据分析工作负载中的小对象的访问提供超低延迟和高吞吐量支持。

- 最大化 GPU 利用率:存储瓶颈常常扼杀 AI 性能,而 WEKA 能帮助消除这一障碍,使数据性能提升 10 倍或更多。在实际部署中,客户的 GPU 利用率从 30-40% 跃升至超过 90%。

- 真正的多租户支持:WEKA 的可组合集群利用容器技术实现逻辑与物理双重隔离,从而提供安全、高性能的 AI 云多租户服务,实现性能零妥协。

- 大规模扩展能力:WEKA 在单一命名空间内可支持多达 32,000 颗 NVIDIA GPU 集群,助力英伟达云合作伙伴在全球范围内实现从 PB 到 EB 级的无缝扩展,而无需担心架构受限。

- 无缝迁移:无论是在数据中心、超大规模云还是新一代云环境,WEKA 统一的软件架构均可实现工作负载的无缝迁移。

基准测试与实际性能表现

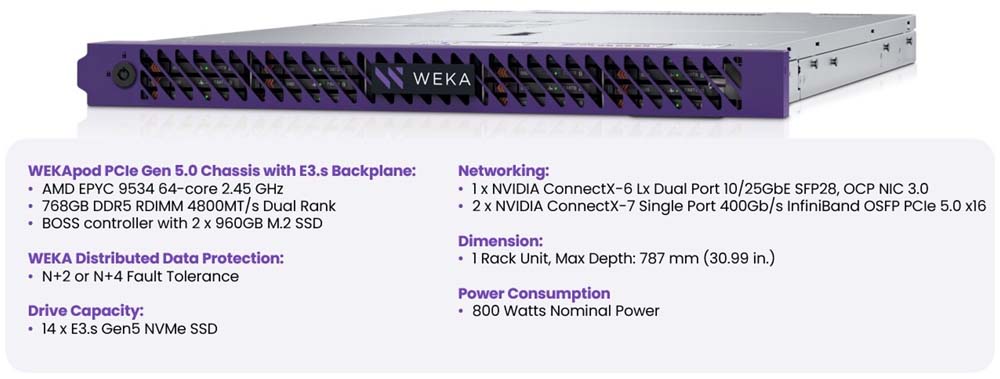

WEKApod Nitro 设备为 NVIDIA 云合作伙伴部署提供了卓越的性能密度和能效:

- 吞吐性能:WEKApod 单节点实现 70GB/s 读取速度(最低配置下可达 560GB/s)和 40GB/s 写入速度(最低配置下可达 320GB/s),确保 Blackwell GPU 持续获得高速数据,最大化利用率。

- 延迟优化:亚毫秒级延迟,确保 AI 训练和推理工作负载延迟最小化,助力实时推理 AI 模型高效运行。

- 扩展性实践:借助 WEKApod,NCP 已实现从 PB 级到 EB 级的数据规模扩展,支持数千个并发工作负载而不牺牲性能。

- GPU 利用率提升:WEKA 的可组合集群利用容器技术实现逻辑与物理双重隔离,从而提供安全、高性能的 AI 云多租户服务,实现性能零妥协。

- 能效优化:WEKApod 优化的数据处理显著降低了每个 AI 工作负载的能耗,为 AI 云服务商降低了整体运营成本。

- NVIDIA 认证:WEKA 荣获 NVIDIA 系统存储解决方案认证,确保为 AI 和数据分析工作负载提供高性能、可扩展且可靠的存储解决方案。

NVIDIA MGX 部署的推荐存储配置

合理的存储配置对确保 AI 训练和推理的最佳性能至关重要。存储性能目标因模型类型、数据集大小和工作负载特征而异。为支持 NVIDIA MGX 系统上的高性能训练和推理,WEKA Data Platform 提供了一套 NVIDIA Blackwell 认证的、可扩展且高吞吐量的存储方案,完美契合现代 AI 工作负载的需求。

对于大规模 AI 训练来说,检查点的读写性能尤为关键,这是一个同步任务,若优化不当,可能会导致训练停滞。大型语言模型(LLM)在检查点阶段需极高写入吞吐量,其需求也会随着模型规模增长而增加。例如,一个5300 亿参数模型可能需要 206 GB/s 的总写入速率,而一个 1 万亿参数模型则可能需要近 389 GB/s 的写入速率。

下表展示了 WEKApod Nitro 设备在满足 NVIDIA GB200 NVL72 机架(最低存储容量 10,924TB)增强型指导/性能要求下的存储密度与认证性能:

通过使用 WEKApod,云服务商可以彻底消除存储瓶颈,确保 Blackwell GPU 始终以最佳状态运行,而无需过度超配。

未来已来:构建 AI 推理时代的基础设施

AI 推理时代需要一种全新的数据基础设施,它不仅要运行快速、高效,还能应对 Token 经济的爆发式增长。现在,借助 WEKA 与 NVIDIA GB200 NVL72 强强联手,AI 云服务商可以同时获得出色的性能、强大的扩展性和安全保障长。

如果您是正在构建下一代 AI 云服务的 NVIDIA 云合作伙伴,现在正是解锁 GPU 潜能的最佳时机,与 WEKA 携手,让您的 AI 云服务更加快速、稳定、简单!