AI 热浪来袭,液冷势在必行

在 AI 算力狂飙的今天,数据中心正面临前所未有的“热力挑战”。传统风冷已力不从心,而直接芯片液冷(Direct-to-Chip Cooling,D2C)正成为下一代 AI 数据中心的“冷静”之选。瑞技全球系统与制冷方案售前工程经理 Curtis Breville 将在本文深入剖析 D2C 直接芯片液冷的技术原理、优势、部署方式、现实挑战,与其在 AI 数据中心的未来前景。

原文作者:

Curtis Breville 是瑞技全球系统与制冷方案售前工程经理,在 IT 行业拥有超过 34 年的从业经验,并在数据中心基础设施领域深耕超过25年。他在液冷、数据存储、系统集成,以及 AI 就绪环境建设等方面积累了深厚的专业知识,曾先后在 CoolIT Systems、AHEAD 和戴尔等全球知名企业担任领导职务,致力于推动高性能计算(HPC)和 AI 工作负载的先进制冷解决方案。Curtis 对直接芯片液冷(Direct-to-Chip Cooling)和下一代热管理技术的深刻理解,使他成为数据中心效率与可持续发展领域备受推崇的权威专家。

液冷需求日益增长

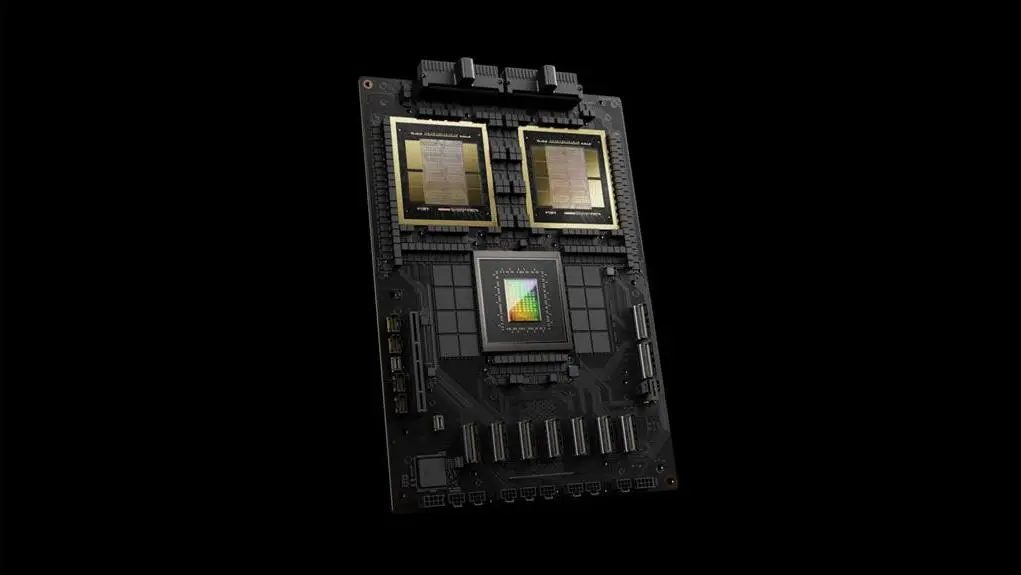

AI 数据中心的硬件性能正以惊人速度提升,散热问题已成为行业发展的瓶颈。以英伟达 Blackwell GB200为例,这款由双 Blackwell B200 GPU 和 Arm Grace CPU 组成的处理器,在 1750 亿参数的 GPT-3 基准测试中,性能是 H100 的 7 倍,训练速度提升 4 倍。然而,性能跃升的同时,其散热需求也水涨船高——GB200 NVL72 机柜功率高达 120kW,远超传统风冷应对极限。

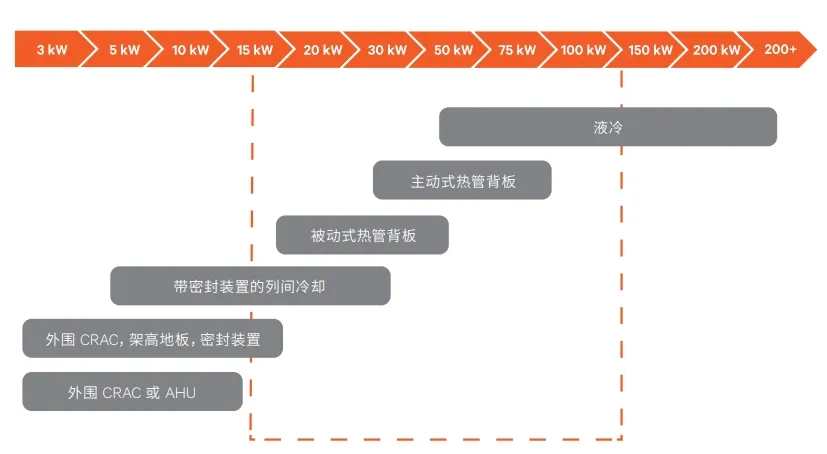

数据中心制冷技术必须不断发展,才能满足其所支持的 IT 系统日益增长的需求。过去,风冷系统通过优化冷源位置,和密封冷热通道的方案,来适应更高的热密度散热需求。但是,当机架密度超过 20kW 时,传统方法的收益逐渐减少。像广受 AI 数据中心青睐的英伟达 NVIDIA Blackwell GB200 这样的高性能芯片,它们产生的热量使传统风冷技术无法提供足够的散热支持。液冷技术,已从“可选升级”变为“生存刚需”,直接芯片(D2C,direct-to-chip)单相液冷技术也成为高性能 AI 数据中心的首选解决方案。

直接芯片液冷的工作原理——精准散热的“冷静哲学”

直接芯片液冷(D2C, direct-to chip),也就是芯片冷板液冷,其核心在于将冷板直接安装在发热组件(如 CPU,GPU,内存模块)上,通过单相冷板或两相冷板来吸收并带走芯片的热量。专用冷却液在冷板内高速循环,精准吸收热量,随后流入冷却剂分配单元 CDU 进行散热,再循环利用。而 CDU 主要分为两大类型:

液-气 CDU(L2A,liquid to air CDU):通过风扇将冷却液降温后循环使用,适用于缺乏水冷基础设施的数据中心。

液-液 CDU(L2L,liquid to liquid CDU):利用数据中心现有的冷却水进行散热,效率更高,但需要对传统数据中心进行适应性改造。

单相液冷和两相液冷的一个关键区别在于是否会产生相变,单相液冷的冷却液始终保持液态,而两相液冷的冷却液会汽化再凝结成液体。虽然两相液却效率更高,但其成本和复杂度较高,因此目前大多数 AI 数据中心选择 D2C 单相直接芯片液冷技术。

CDU 的规模与部署方式——“量体裁衣”的散热方案

数据中心可根据工作负载的强度、场地布局和现有制冷基础设施,选择不同尺寸和部署方式的 CDU,主要类型包括:

- 机架式 CDU:通常是一个 4U 大小的紧凑型单元,部署在服务器机架内,通过歧管系统为机架内所有服务器分配冷却液散热。

- 行式 CDU:安装在机架行末或行中,通过二次流体网络(SFN)为多个机架散热。

- 设施式 CDU:大型数据中心制冷解决方案,部署在独立的机房中,支持多兆瓦级散热。需要强大的 SFN 设计来有效分配冷却液。

- 后门热交换器(RDHx):挂载在服务器机架的后门,使用冷却水或特制的冷却液吸收机架排出的热空气,达到局部散热效果。

D2C 直接芯片液冷优势——更快,更省,更绿

AI 负载比传统数据中心服务器要求更高的功率密度,因此制冷效率是一个重要因素。直接芯片液冷相比传统风冷和浸没液冷方案,具有以下几个明显优势:

- 高效散热:通过直接将热量从处理器传递给冷却液,显著降低热阻,提高冷却效率。

- 节能降耗:传统风冷系统需要大量的风扇和散热器来保持最佳温度,而 D2C 液冷能显著降低能耗,从而节省长期的运营成本。

- 灵活扩展:通过模块化的 CDU 设计,数据中心可以在不大规模改造设施的情况下,逐步升级制冷基础设施。

- 节约用水:与传统的蒸发制冷不同,D2C液冷系统采用闭环冷却液循环,最大限度地减少用水量,更加绿色环保。

液冷普及的挑战与未来趋势

尽管液冷前景光明,但它的推广仍面临一些挑战:

- 老旧设施改造:为风冷设计的老旧数据中心,需要进行基础设施升级,才能支持 L2L 液冷,初期成本较高。

- 冷却液选择:需要选择兼顾热导性、耐腐蚀性和耐久性的理想冷却液。

- 标准化难题:虽然行业内有推动液冷标准的声音,但 CDU 型号、管路设计和冷却液配方的差异仍然带来兼容挑战。

AI 数据中心液冷的未来

随着 AI 工作负载越来越密集,耗电量越来越大,液冷技术也会不断进步。行业正朝着混合制冷解决方案转型,将 D2C 直接芯片液冷与后门热交换器结合,来实现最大化制冷效率。同时,如果数据中心能有足够水源,L2L CDUs(液-液单相制冷单元)也会更受欢迎,进一步提升性能和可持续性。

瑞技:您的“冷静智囊”——助力 AI 数据中心高效运行

直接芯片液冷已成为 AI 数据中心的首选解决方案,它能提供卓越的效率、可扩展性和长期成本效益。随着处理器性能不断提升,散热需求日益增长,数据中心必须采用创新型制冷技术来保持高性能与可持续发展。深入了解 D2C 直接芯片液冷技术及其部署策略,对于在现代 AI 基础设施种做出明智决策至关重要。

瑞技(ByteBridge)专注于为客户提供量身定制的高效制冷解决方案,精准满足您的独特需求。我们在液冷领域,尤其是 D2C 直接芯片液冷解决方案,拥有深厚的专业知识,能够助力客户设计并实施优化、高效且节能的系统,帮助数据中心实现无缝扩展并充分释放其潜能。选择瑞技,您将拥有一个值得信赖的合作伙伴,与您携手应对 AI 数据中心的制冷挑战,共同打造面向未来的 AI 就绪数据中心,为 AI 工作负载提供坚实支持。